Elon Musk, Bill Gate et Stephen Hawking partagent tous les trois une même opinion : d’après eux, l’intelligence artificielle est un grand danger pour l’avenir de l’humanité.

Il n’est pas rare d’entendre des propos apocalyptiques à l’égard de nouvelles technologies, notamment dans les sphères complotistes diverses. Mais, ici, il s’agit de l’opinion de physiciens, ingénieurs et entrepreneurs renommés.

Du coup, nous pouvons raisonnablement nous interroger : ce danger est-il bien réel ou les propos de ces personnalités sont-ils excessifs ?

Car lorsqu’on regarde ce que l’on fait concrètement avec de l’intelligence artificielle aujourd’hui, cela n’a pas l’air dangereux. Cependant, il est vrai que cette technologie progresse rapidement. L’IA est partout : elle se trouve derrière YouTube, Google ou encore Netflix. Elle se trouve dans nos téléphones, montres, voitures et même certaines brosses à dents. Cela ne peut pas être sans risques.

Dans cet article, nous allons essayer de répondre à ces questions. Nous allons voir ce qui effraye ces personnalités pourtant très intelligentes. Et nous allons voir pourquoi Elon Musk a investi 1 milliard de dollars pour protéger l’humanité des dangers de l’intelligence artificielle.

L’intelligence artificielle étroite

Il est probable que ce ne soit ni Google Traduction ni les filtres SnapShat qui effrayent Elon Musk ou Bill Gate. Bien que ces outils soient basés sur de l’intelligence artificielle.

En fait, pour comprendre leurs inquiétudes, il faut distinguer deux concepts, proposés par la communauté scientifique il y a une bonne vingtaine d’années : l’intelligence artificielle étroite d’une part, et l’intelligence artificielle générale de l’autre.

Nous allons utiliser ces termes dans un sens très simple dans cet article, sachez que la réalité à laquelle ils renvoient peut être complexe et c’est un sujet récurrent de polémique entre passionnés.

Pour comprendre ce qu’est l’intelligence artificielle étroite, prenons un exemple concret. Lorsque Netflix vous recommande une vidéo plutôt qu’une autre, le modèle d’intelligence artificielle qui se trouve derrière se comporte un peu comme un cheval avec des œillères : il est focalisé sur un seul objectif, qui est de vous recommander la meilleure vidéo. L’algorithme ne sait rien faire d’autre que cela ; impossible de lui demander, par exemple, de résumer le contenu d’une vidéo.

Ce genre d’algorithmes relève de ce qu’on appelle l’intelligence artificielle étroite : le modèle est limité à un champ d’action précis et ne peut pas se généraliser à d’autres cas d’usages.

Le danger

Même s’ils ont l’air a priori inoffensifs, ces algorithmes peuvent être dangereux. Cela vient de ce qu’ils jouent un rôle de plus en plus important dans nos vies : ils servent pour les crédits bancaires, le pilotage de véhicule, le recrutement, etc.

Du coup, si ces algorithmes sont défaillants ou mal sécurisés, ils peuvent créer des accidents, de la discrimination, la diffusion d’informations erronées, etc.

Et pourtant, ces risques ne sont rien à côté d’un autre danger, et c’est celui-là qui effraye nos amis Elon Musk et Bill Gate : il s’agit de l’autre type d’intelligence artificielle, qui est beaucoup plus puissant.

L’intelligence artificielle générale

Mais qu’est-ce que c’est, du coup, l’intelligence artificielle générale ? En gros, ce serait un peu l’intelligence artificielle ultime. Pour faire simple, vous pouvez voir cela comme une famille de modèles qui serait capable de faire tout ce qu’on lui demande : de la reconnaissance du sens d’une phrase, jusqu’à la composition d’une musique, en passant par l’apprentissage d’un jeu de plateau, etc.

Et un tel modèle pourrait apporter beaucoup à l’humanité. En fait, ce serait un peu la cellule souche de l’intelligence artificielle si vous voulez ; car au lieu d’avoir un modèle par cas d’utilisation, nous pourrions utiliser un algorithme universel, qui pourrait servir pour tous les cas d’usages.

Comme nous le disions plus haut, sachez que ce concept d’intelligence artificielle fait l’objet de nombreux débats. Pour certains c’est un concept qui va très loin. Ces gens imaginent qu’un tel modèle serait capable de ressentir des émotions, d’apprendre de manière totalement autonome, voire d’être conscient de son existence.

Voilà, vous voyez maintenant probablement l’idée qui se trouve derrière ce concept. Et vous imaginez sans doute les bénéfices que cela peut apporter. Mais vous imaginez certainement aussi le danger qu’elle peut représenter.

Le danger

Qui parmi vous utilise encore des cartes routières avant de faire un trajet en voiture ? Qui parmi vous utilise encore les annuaires téléphoniques en papier ?

Nous sommes probablement d’accord sur le fait que la plupart des gens ne font plus cela. Et pourquoi ? Sans doute parce que l’on fait confiance à l’algorithme de Waze pour nous amener à bon port. Peut-être aussi parce que nous savons que Google va nous fournir rapidement le numéro de téléphone du commerçant que l’on veut joindre.

Et d’un côté, c’est génial, car ces outils nous enlèvent de la charge mentale : nous n’avons plus à chercher, ni même à réfléchir, et nous pouvons nous concentrer sur des tâches où l’on a davantage de valeur ajoutée.

Pourtant, petit à petit, nous perdons notre capacité à prendre nos propres décisions. Car lorsque nous choisissons une vidéo YouTube parce qu’elle a été recommandée par l’algorithme, il ne s’agit pas d’une décision libre et consciente. Et progressivement, nous nous soumettons.

Et c’est regrettable, car cette capacité à penser et prendre des décisions, c’est cela qui fait de nous des humains et non des animaux.

Ce raisonnement, c’est celui de Yuval Noah Harai dans son livre Homo Deus. Pour lui, plus l’intelligence artificielle va devenir puissante, plus l’humain va lui déléguer ses décisions et donc, d’une certaine manière, lui déléguer son humanité.

Et le problème, c’est que nous pourrions arriver à un point de non-retour, dans lequel les humains ne pourraient plus se passer de ces algorithmes. Et lorsque nous serons tous dépendants de l’intelligence artificielle, comme un toxicomane à sa dose de drogue, la question la plus importante sera alors : qui est le propriétaire de cette intelligence artificielle ? Qui contrôle… ce qui contrôle nos décisions ? Est-ce que ces gens seront dignes de confiance ?

Ce qui est certain, c’est qu’il ne faut pas que cela tombe entre de mauvaises mains, et c’est exactement ce que se sont dit deux entrepreneurs : Elon Musk et Sam Altman. Vous allez voir.

Création d’OpenAI

Pour éviter qu’une telle technologie ne tombe entre de mauvaises mains, Elon Musk et Sam Altman ont créé et financés un laboratoire de recherche dans l’intelligence artificielle : OpenAI.

Ce laboratoire devait être la solution à la menace dont on vient de parler plus haut. Sa mission était d’atteindre l’intelligence artificielle générale. Mais de l’atteindre avant que des entreprises ou des états malveillants n’y parviennent. Et le but étant que cela bénéficie à l’ensemble de l’humanité. Cette mission est encore visible aujourd’hui sur le site Web du laboratoire.

Pourtant cet objectif est extrêmement difficile à atteindre, allaient-ils être capables d’y arriver ?

Le pré-entraînement génératif

En 2018, l’équipe d’Alec Radford surprend tout le monde en publiant un article qui allait avoir un impact énorme dans la communauté des chercheurs et entrepreneurs.

Il a un titre plutôt mystérieux : « Améliorer la compréhension du langage avec le pré-entraînement génératif. »

En anglais, on parle de generative pre-training ; d’où l’acronyme GPT. Et vous avez sans doute déjà entendu parler de la troisième génération de ce modèle : GPT-3.

Mais est-ce que vous savez ce qu’il y avait de vraiment innovant lorsque cet article a été publié, en 2018 ?

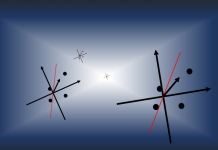

Nous savons tous qu’ils ont utilisés du machine learning, et plus précisément du deep learning — c’est-à-dire un certain type de modèle de machine learning, basé sur des réseaux de neurones artificiels.

Mais ça, ce n’était pas vraiment innovant.

Ce que vous savez sans doute également, c’est qu’ils n’ont pas utilisé n’importe quel modèle de deep learning ; ils ont utilisé une architecture de type Transformers.

Alors je ne vais pas rentrer dans le détail, mais ici, ce que vous devez savoir, c’est que les Transformers à la base, ils permettent de traduire ou générer du texte — un peu comme quand Google rédige la fin de vos e-mails.

Et ce sont des modèles très performants, grâce à une architecture spéciale, basée notamment sur des mécanismes d’attention.

Mais le fait d’utiliser des « transformers », ce n’était pas non plus innovant, car OpenAi n’a pas inventé cette architecture. C’est Google qui l’a fait, et c’était déjà en 2017.

L’innovation elle se trouve donc ailleurs ; elle vient de la combinaison des Transformers avec une autre technologie : le transfer learning.

Le transfer learning

Dans son modèle GPT, OpenAI utilise une technologie qu’on appelle le transfer learning.

Mais qu’est-ce que c’est le transfer learning ? Nous allons tenter une métaphore : vous pouvez voir cela comme de la sauce béchamel. La comparaison est peut-être un peu surprenante, mais nous allons expliquer cela.

Si vous faites une grosse casserole de sauce béchamel, ensuite, vous pouvez stocker cette sauce dans votre réfrigérateur. Et cela a de nombreux avantages.

D’abord, vous pouvez en prendre une louche chaque fois que vous voulez faire une lasagne. Mais si vous voulez une saveur différente, vous pouvez prendre cette sauce comme base et ajouter, par exemple, un jaune d’œuf et du fromage. Cela devient alors une autre sauce : une sauce Mornay. Et c’est bon avec les œufs pochés.

En bref, avec une même sauce de base, en faisant quelques petits ajustements, vous pouvez créer d’autres sauces, pour accompagner d’autres plats. D’une certaine manière, le transfer learning est un peu la même chose :

- D’abord, quelqu’un va construire un modèle de base. Ce sera souvent un gros laboratoire de recherche, ou une société privée, parce que ces modèles sont en général volumineux et il faut avoir pas mal d’argent pour payer la facture des serveurs.

- Et ce modèle de base on va le stocker dans un hub, c’est-à-dire une sorte de plateforme sur Web où il sera stocké et disponible pour le téléchargement. Un exemple de ce type de plateforme, c’est le hub de HuggingFace. Il y a plein de modèles de base que l’on peut télécharger, et nous pouvons ensuite les ajuster nous-mêmes.

Et cela a peut-être l’air simpliste expliqué comme cela, et pourtant, cette technologie elle a plein d’avantages : grâce à cela, un petit développeur avec peu de moyens comme vous et moi, il est capable de faire des modèles d’IA très performant sans faire exploser son portefeuille.

Et comment ? En téléchargeant un modèle de base, puis en ajoutant quelques claques de neurones, et puis en entraînant à nouveau le modèle. Mais cette fois-ci, il aura besoin de beaucoup moins de données d’entraînement, car une grande partie du travail aura déjà été stockée dans le modèle de base.

Et du coup, comme vous le voyez ici, le modèle il aura été “entraîné” deux fois. Dans le jargon, on dit que le modèle de base, est préentraîné, et lorsqu’on l’ajuste pour faire un modèle final, on dit qu’on fait du fine-tuning.

Maintenant que je vous ai présenté ces quelques concepts. Vous avez sans doute une meilleure idée de ce que veut dire generative pre-training : on a un modèle qui a été préentraîné pour générer du texte.

L’innovation de GPT

Donc OpenAI a créé un modèle de génération de texte préentraîné. C’est super, c’est innovant. Mais qu’est-ce que ça peut apporter à la société ? Car n’oublions pas que la mission d’OpenAI, c’est de découvrir l’intelligence artificielle générale et de la rendre accessible et bénéfique pour l’humanité.

Le laboratoire a remarqué qu’en préentraînant un modèle pour générer du langage, on obtenait un modèle de base, qui permettait de réaliser d’autres tâches. Clarifions cela : bien sûr, on peut utiliser GPT pour générer du texte ; c’est pour cela qu’il a été conçu, c’est un modèle génératif.

Mais, ce qu’ils ont constaté, c’est qu’il était possible de fine-tuner ce modèle génératif pour qu’il réalise d’autres tâches que la génération de texte. Par exemple, il est possible de fine-tuner GPT pour traduire du texte ; nous pouvons aussi le faire écrire du code dans un langage de programmation ; il est également possible de créer un système qui réponde à des questions, etc.

Bien entendu, OpenAI ne s’est pas arrêté là. Après les succès encourageants de GPT, le laboratoire a essayé de voir plus grand. Et ce faisant, ils ont découvert quelque chose de surprenant.

Le Graal ?

Après le succès de GPT, le laboratoire a ensuite créé GPT-2 et puis GPT-3. En gros, ce sont à peu près les mêmes modèles de deep learning, mais à chaque nouvelle version, ils ont augmenté le nombre de calques, de neurones, et la quantité de texte sur lequel ces modèles étaient entraînés.

Pour vous donner une idée de la taille croissante de ces différentes versions :

- Le premier modèle a été entraîné sur 7000 livres environ, pour un total d’à peu près 4 GB.

- GPT-2 a reçu environs 8 millions de documents provenant d’un jeu de données qui s’appelle WebText, totalisant 40 GB.

- Quant à GPT-3, il a été entraîné sur des millions de publications provenant de réseaux sociaux, de Wikipédia, mais également sur des livres, ou encore sur du code. Il est à peu près 50 fois plus grand que GPT-2.

Et en faisant grossir leurs modèles, ils ont découvert quelque chose de surprenant : le modèle préentraîné est devenu capable de faire d’autres choses que la génération de texte.

Alors là, vous allez peut-être être confus et vous dire que c’était déjà le cas avant, qu’on pouvait ajuster le modèle pour qu’il fasse d’autres tâches : c’est le fameux fine-tuning. Mais avec GPT-3, on n’est même plus obligé de fine-tuner le modèle. Le modèle s’ajuste tout seul en fonction du contexte.

Conclusion

Nous avons donc un modèle universel, capable de réaliser plusieurs tâches et s’adapter à différent contexte, n’est-ce pas l’objectif de l’intelligence artificielle générale ? D’une certaine manière, oui : nous pouvons considérer que nous sommes aux prémisses de ce que pourra devenir l’intelligence artificielle générale.

Il semblerait que la génération de langage, et plus généralement la maîtrise, par la machine du langage humain, lui permette de réaliser d’autres tâches intellectuelles : disserter, traduire, résumer, répondre à des questions.

Cependant, l’algorithme a encore ses limites : bluffant lorsqu’on reste sur des sujets généraux, il montre rapidement ses faiblesses lorsqu’on aborde des sujets techniques ou de niche.

Le modèle est également loin d’être économique, voire écologique : il a fallu une puissance de calcul invraisemblable pour entraîner le modèle. Cela se chiffre en million d’euros.

Pour pouvoir le financer, ils ont d’ailleurs dû trouver un accord avec Microsoft, accord qui leur donne malheureusement l’accès exclusif au code source. Ce qui dévie OpenAI de sa mission initiale.

De plus, gPT-3 n’a été entraîné qu’une fois, avant la pandémie de la Covid-19. Il n’est donc déjà plus capable de répondre à des questions liées à l’actualité.

Mais OpenAI ne va sans doute pas s’arrêter là ; nous verrons ce que donnera GPT-4, en espérant qu’ils garderont leur volonté de transparence et, on l’espère, qu’ils reviendront à une culture plus open source, dans la mesure de ce qui est possible au vu de leurs contraintes financières.

Crédit de l’image de couverture : HaeB, CC BY-SA 4.0, via Wikimedia Commons. « Pioneer Building » où se trouvent les entreprises OpenAI et Neuralink, à San Francisco.

![Spark 3 : à la découverte des RDD [Part 2]](https://penseeartificielle.fr/wp-content/uploads/2022/02/fire-1905608_1280-218x150.jpg)

![Installation de Spark 3 sous Windows [Part 1]](https://penseeartificielle.fr/wp-content/uploads/2022/02/pexels-fabiano-rodrigues-1662298-218x150.jpg)