Il y a quelques semaines, Quantum AI Lab de Google présentait un tout nouveau processeur quantique : le Bristlecone.

Si ce n’est pas le premier du genre, deux records viennent d’être battus haut la main : le nombre de qubits que peut atteindre le processeur et son taux d’erreur très faible, sur lesquels nous allons revenir.

Qu’est-ce qu’un processeur quantique, en quoi est-ce une révolution et où allons-nous avec cette nouvelle technologie ?

Processeur quantique et ordinateur quantique

Dans un article précédent, nous vous présentions ce qu’est un algorithme quantique et comment il fonctionne : grâce à des qubits au lieu des traditionnels bits. Prenant leurs valeurs entre 0 et 1 (au lieu de valoir soit 0 soit 1), les qubits offrent des capacités de calcul phénoménales…

… sous réserve de pouvoir maintenir l’état de superposition quantique !

Par exemple, pour pouvoir résoudre le problème du voyageur de commerce (trouver le plus court chemin pour quelqu’un qui doit passer par 3 villes), des qubits simulent le passage en même temps par tous les chemins possibles et retiennent le plus court. Pour y arriver, ils ont besoin de rester dans cet état où ils « peuvent tout faire en parallèle », ce qui s’avère très difficile car la moindre interaction du monde avec un qubit brise cet état (on parle de décohérence) !

Vous l’aurez compris, un ordinateur quantique qui utilise donc un processeur quantique (manipulant des qubits) est extrêmement plus rapide qu’un ordinateur classique et va révolutionner le monde, SI on parvient à garder les qubits dans l’état superposé assez longtemps.

Une révolution signée Google

De nombreux progrès ont été fait ces dernières années, chaque acteur majeur battant tour à tour le record :

- 2 qubits en 1998 (IBM),

- 7 en 2001 (IBM),

- 14 en 2011 (Université d’Innsbruck),

- 17 en mai 2017 (IBM) puis

- 17 en septembre 2017 (Intel).

A ce moment-là, IBM parvient à faire fonctionner pendant quelques micro-secondes une version à 50 qubits, ce qui est le record… et la limite théorique que l’on pouvait atteindre (cf suprématie quantique).

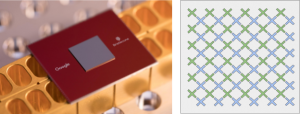

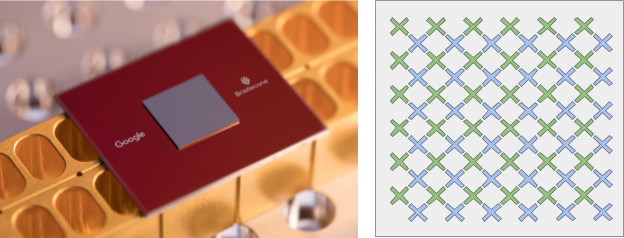

Si Microsoft et IBM se disputent les ordinateurs quantiques, Google frappe un grand coup dans la course avec son nouveau processeur baptisé Bristlecone. L’architecture a entièrement été revue depuis leurs premiers processeurs, et celui-ci permet d’intégrer jusqu’à 72 qubits, ce qui est bien au-delà de la limite (49 qubits) : aucun ordinateur classique ne devrait être capable de le simuler.

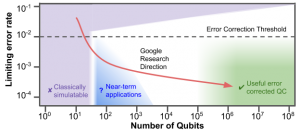

Néanmoins, la puissance brute ne suffit pas, car ces processeurs sont sensibles aux erreurs. Régulièrement, les qubits commettent de petites fautes (à cause, entre autre, du phénomène de décohérence abordé plus haut). Google est bien au courant et fixe sa stratégie sur diminuer au maximum les erreurs des qubits pour pouvoir exploiter au mieux sa puce !

Ainsi, Bristlecone ne commet que 1% d’erreur pour la mesure, 0.1% pour les portes de 1 qubit (NOT par exemple) et surtout 0.6% pour les portes de 2 qubits (AND, OR par exemple).

Ces résultats, très encourageants, poussent le géant du web à viser plus haut encore, avec 0.5% sur les portes de 2 qubits. Car faire moins d’erreurs signifie, avant tout, passer moins de temps à revérifier ses calculs, et avoir des résultats plus précis (donc exploitables)… « Pour que l’informatique quantique dépasse le cadre des laboratoires, il faudra des processeurs [quantiques] à plusieurs milliers de qubits et des taux d’erreurs de moins de 0.01% ».

Enfin, Google souhaite se placer comme référence en matière d’évaluation des processeurs quantiques, puisque l’équipe de Google Quantum AI Lab a développé un outil de mesure (benchmark) dédié. Celui-ci, en appliquant des états quantiques aux circuits aléatoires, mesure la sortie du système et la compare à celle d’un ordinateur classique. Cette comparaison permet, pour l’instant encore, d’évaluer les puces, sous réserve d’agir sur un grand nombre de qubits situés à tous les niveaux.

On voit donc, au travers de tous ces efforts, la volonté qu’a Google de se placer en tête des ordinateurs quantiques en introduisant la course aux faibles taux d’erreurs, mais aussi aux outils connexes comme les benchmark.

Ceci étant, plusieurs années (décennies) nous séparent encore des premières applications concrètes et grand public (même si IBM a donné accès à sa puce sur Internet).

Crédit de l’image de couverture : Google AI Blog

![Spark 3 : à la découverte des RDD [Part 2]](https://penseeartificielle.fr/wp-content/uploads/2022/02/fire-1905608_1280-218x150.jpg)

![Installation de Spark 3 sous Windows [Part 1]](https://penseeartificielle.fr/wp-content/uploads/2022/02/pexels-fabiano-rodrigues-1662298-218x150.jpg)